da Sceglieresti di vincere in una competizione diretta: un moderno agente di intelligenza artificiale o un topo? Isacco KovarWu Cai Istituto di Neuroscienze Uno studioso post-dottorato interdisciplinaree Chris Doyle, un ricercatore di machine learning presso la Stanford University, ha deciso di metterli l’uno contro l’altro per scoprirlo. Lavora in un laboratorio Nick HaberKauvar e Doyle, un assistente professore presso la Graduate School della Stanford University, hanno progettato un compito semplice basato sul loro interesse di lunga data per una serie di abilità in cui gli animali eccellono naturalmente: esplorare e adattarsi all’ambiente circostante.

Kauvar ha posizionato un mouse in una piccola scatola vuota e allo stesso modo ha posizionato un agente di simulazione AI in un’arena virtuale 3D vuota. Poi ha piazzato una pallina rossa in entrambi gli ambienti. Kauvar è stato misurato per vedere quale sarebbe stato più veloce per esplorare il nuovo oggetto.

Il test ha mostrato che il topo si è avvicinato rapidamente alla palla e ha interagito ripetutamente con essa nei minuti successivi. Ma l’agente AI non sembrò accorgersene. “Non era previsto”, ha detto Kovar. “In effetti, eravamo consapevoli che anche con un algoritmo all’avanguardia, c’erano delle lacune nelle prestazioni”.

Gli scienziati si sono chiesti: potrebbero usare comportamenti animali apparentemente semplici come ispirazione per migliorare i sistemi di intelligenza artificiale?

Questa domanda ha motivato Kauvar, Doyle e lo studente laureato Linqi Zhou e Haber a progettare un nuovo metodo di allenamento chiamato bizarre replay, che programma gli agenti di intelligenza artificiale per riflettere su se stessi sulle cose più interessanti e nuove che hanno incontrato di recente. L’aggiunta di uno strano replay era tutto ciò che serviva all’agente AI per avvicinarsi e gestire la palla rossa più velocemente. Inoltre, ha notevolmente migliorato le prestazioni su un gioco basato su Minecraft, chiamato Crafter. I risultati di questo progetto sono attualmente pubblicati in Servizio di prestampa arXivall’International Machine Learning Conference del 25 luglio.

Imparare attraverso la curiosità

Può sembrare che la curiosità offra solo vantaggi intellettuali, ma è importante per la nostra sopravvivenza, sia per evitare situazioni pericolose che per trovare beni di prima necessità come cibo e riparo. Questa palla rossa nell’esperimento potrebbe perdere un veleno mortale o coprire un pasto nutriente, e sarebbe difficile dire quale sia quale se la ignoriamo.

Questo è il motivo per cui laboratori come Haber hanno recentemente aggiunto Curiosity Signal per guidare il comportamento degli agenti di intelligenza artificiale e, in particolare, gli agenti di apprendimento per rinforzo profondo basati su modelli. Questo segnale dice loro di selezionare l’azione che porterà a un risultato più interessante, come aprire la porta, piuttosto che ignorarla.

Leggi lo studio completo, Uno strano riavvio dell’adattamento basato sul modello

Ma questa volta, il curioso team ha usato l’intelligenza artificiale in un modo nuovo: per aiutare un agente a conoscere il suo mondo, non solo a prendere una decisione. “Invece di scegliere cosa fare, vogliamo scegliere cosa pensare, più o meno: da quali esperienze del nostro passato vogliamo imparare”. Kovar ha detto. In altre parole, volevano incoraggiare l’agente AI a riflettere su se stesso, in un certo senso, sull’esperienza più interessante o stravagante (e quindi legata alla curiosità). In questo modo, all’agente può essere chiesto di interagire con l’oggetto in vari modi per saperne di più, il che dirigerà la sua comprensione dell’ambiente e forse incoraggerà anche la curiosità verso altri oggetti.

Per ottenere l’autoriflessione in questo modo, i ricercatori hanno modificato un metodo comune utilizzato per addestrare agenti di intelligenza artificiale, chiamato riesperienza. Qui, l’agente memorizza i ricordi di tutte le sue interazioni e poi ne riproduce casualmente alcune per imparare di nuovo da esse. È stato ispirato dalla ricerca sul sonno: i neuroscienziati hanno scoperto che una regione del cervello chiamata ippocampo “riproduce” gli eventi della giornata (riattivando neuroni specifici) per rafforzare i ricordi. Negli agenti di intelligenza artificiale, la sperimentazione del replay ha portato a prestazioni elevate in scenari in cui l’ambiente cambia raramente e vengono date chiare ricompense per i comportamenti corretti.

Ma per avere successo in un ambiente in evoluzione, hanno ragionato i ricercatori, avrebbe più senso per gli agenti di intelligenza artificiale dare la priorità alla riproduzione delle esperienze più interessanti in primo luogo – come l’apparizione di una nuova palla rossa – piuttosto che riprodurre la stanza virtuale vuota su e ancora.

Hanno chiamato il loro nuovo metodo lo strano replay e hanno scoperto che funzionava all’istante. “Ora, all’improvviso, il cliente sta reagendo alla palla molto più rapidamente”, ha detto Kovar.

Ma non si sono fermati qui. Hanno anche aggiunto uno strano riavvio di agenti di intelligenza artificiale che giocano a un gioco chiamato Crafter, che è un test standard di risoluzione creativa dei problemi per gli agenti di intelligenza artificiale, Dove – come in Minecraft – gli agenti devono capire come sopravvivere e adattarsi imparando come Raccogli legno e pietra, crea un piccone e raccogli il ferro per creare strumenti aggiuntivi. Il bizzarro metodo di riproduzione ha aumentato il punteggio attuale da 14 a 19 (gli umani di solito ottengono un punteggio di circa 50) – con “solo questo cambiamento”, ha detto Kauvar.

Futuro curioso

Il successo del metodo di ricorsione esotica in compiti sia semplici che complessi indica che sarà importante per un’ampia gamma di ricerche sull’IA in futuro. “L’obiettivo generale di questo lavoro – creare agenti che possano trarre vantaggio dall’esperienza passata e adattarsi bene esplorando in modo efficiente ambienti nuovi o mutevoli – porterà a tecnologie più adattive e flessibili, ha affermato Haber, dai robot domestici agli strumenti di apprendimento personale.

Kovar chi Lavoro post dottorato Diretto congiuntamente da Haber e dal neuroscienziato Karl Deisseroth, il professore D.H. Chen nei dipartimenti di bioingegneria e psichiatria è entusiasta di continuare il tema dell’ispirazione dal comportamento animale per migliorare i sistemi di intelligenza artificiale: ha in programma di continuare a testare topi e agenti di intelligenza artificiale su compiti più complessi per confrontare il loro comportamento e le loro capacità. “Molte persone si lamentano dicendo che traggono ispirazione dagli animali, ma qui stiamo costruendo un ponte diretto, non un ponte misterioso. Stiamo cercando di fare esattamente la stessa cosa”. [tasks],” Egli ha detto.

Kauvar spera che un lavoro come questo contribuirà a “collegare il legame” tra la ricerca sull’IA e le neuroscienze e avvantaggerà anche la nostra comprensione del comportamento animale e dei processi neurali di base. “Puoi immaginare che l’intero approccio potrebbe produrre nuove ipotesi ed esperimenti che non erano nemmeno stati pensati prima”, ha detto.

La missione di Stanford HAI è far progredire la ricerca, l’istruzione, la politica e le pratiche sull’IA per migliorare la condizione umana. saperne di più.

“Pluripremiato specialista televisivo. Appassionato di zombi. Impossibile scrivere con i guantoni da boxe. Pioniere di Bacon.”

More Stories

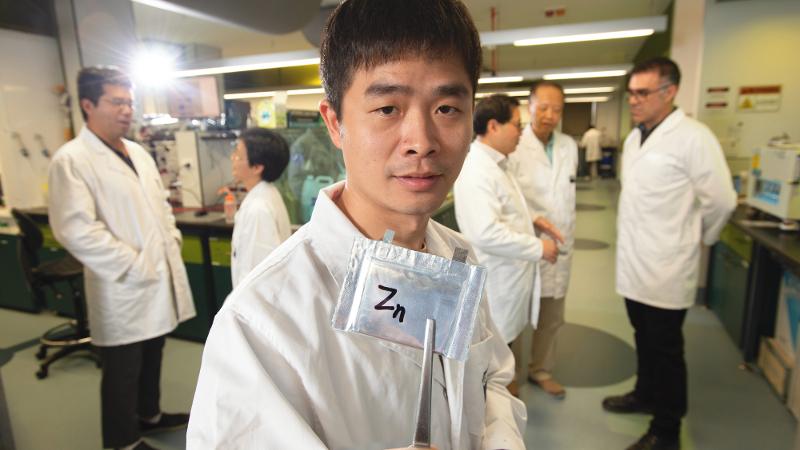

La svolta nella tensione apre la strada a batterie sicure e convenienti

Il sistema I/O adattivo di ORNL migliora il calcolo ad alte prestazioni

Recensione: PreSonus Eris Pro 4